大型语言模型对学习认知负载的影响分析.pdf

本文是一项关于使用大型语言模型(LLM)如ChatGPT对人类认知影响的研究。研究调查了在撰写论文时使用LLM所带来的认知成本。

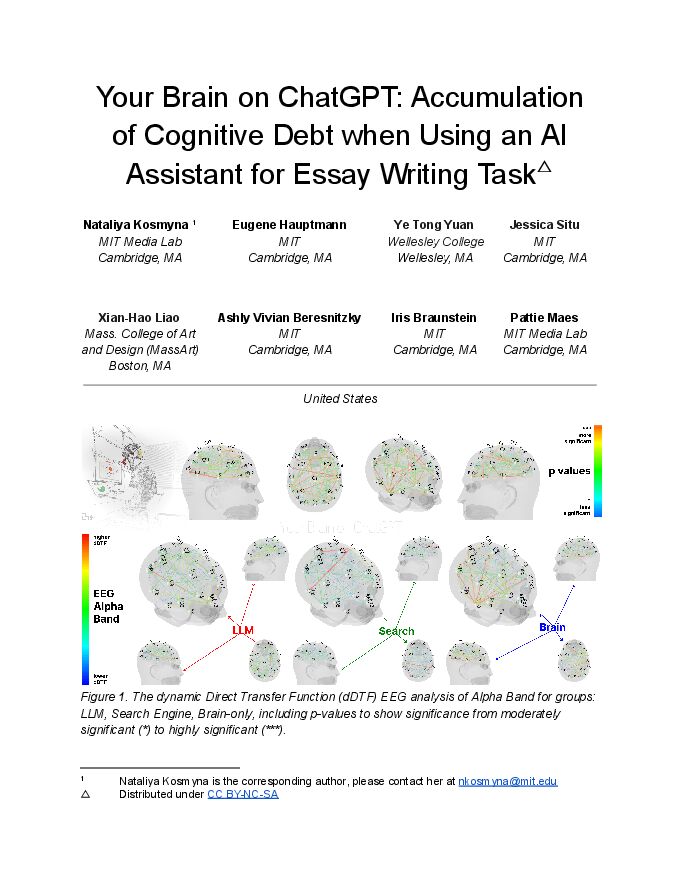

研究将参与者分为三组:LLM组、搜索引擎组和纯人脑组,要求他们使用指定的工具(或不使用工具)撰写论文。通过脑电图(EEG)记录参与者的脑活动,并进行自然语言处理(NLP)分析和访谈,评估认知参与度和认知负荷。

研究发现,LLM、搜索引擎和纯人脑组在神经连接模式上存在显著差异,反映了不同的认知策略。外部支持越多,大脑连接越弱。LLM组表现出最弱的整体连接。在第四次实验中,原本LLM组转为纯人脑写作的参与者表现出较弱的神经连接,而原本纯人脑写作转为LLM组的参与者则表现出更高的记忆回忆和广泛的脑区重新激活。访谈显示,LLM组参与者对自己所写论文的拥有感较低。LLM的使用对学习技能产生了可衡量的负面影响,长期来看,LLM组的参与者在神经、语言和评分等各个层面都比纯人脑组表现更差。

研究还探讨了搜索和LLM中的“回声室”效应,即用户可能陷入强化现有信念的信息环境中。论文分析了命名实体识别(NER)、n-gram,并使用PaCMAP进行嵌入聚类分析,以探究不同写作方法对语言使用的影响。结果表明,使用LLM会影响脑部活动、语言模式和认知所有权,长期来看可能会降低学习能力。

总体而言,研究结果表明,虽然LLM可以提供便利和效率,但过度依赖LLM可能会对认知发展和学习产生负面影响。因此,需要谨慎使用LLM,并在教育环境中促进批判性思维和自主学习。

相关报告

-

1.9 MB 35页 GPTs 大型语言模型对劳动力市场影响潜力的早期研究.pdf

-

1.87 MB 74页 大型语言模型的知识蒸馏与数据集蒸馏:新兴趋势、挑战与未来方向.pdf

-

4.09 MB 53页 基于大型语言模型的代理的兴起和潜力:一项调查.pdf

-

1.91 MB 32页 大模型如何判决?从生成到判决:大型语言模型作为裁判的机遇与挑战.pdf

-

1.33 MB 17页 人民币汇率波动对上市公司盈利的影响分析-中银证券-20230929.pdf

-

3.73 MB 45页 2023中国重新开放对全球旅游业的影响分析-前瞻产业研究院-202304.pdf

-

3.32 MB 43页 2023中国重新开放对全球旅游业的影响分析-前瞻产业研究院-202302.pdf

-

2.92 MB 23页 疫情对日本食品饮料行业影响分析(二):调味品具有穿越疫情的能力2022年12月食品饮料行业报告

-

1.83 MB 75页 新冠肺炎疫情对若干行业的影响分析.pdf

-

838.59 KB 75页 上海交通大学:新冠肺炎疫情对若干行业的影响分析[75页].pdf

-

2.02 MB 24页 新冠疫情对宏观经济的影响分析-200211[24页].pdf

-

1.45 MB 18页 大消费行业专题报告:新型冠状病毒肺炎疫情对大消费行业的影响分析-200203[18页].pdf

-

1.45 MB 75页 新冠肺炎疫情对若干行业的影响分析[75页].pdf

-

1.09 MB 17页 “新冠”疫情对宏观经济和市场的影响分析[17页].pdf

-

1.83 MB 22页 肺炎疫情对节后我国股票市场的影响分析[22页].pdf

-

1.36 MB 18页 新型冠状病毒肺炎疫情对大消费行业的影响分析[18页].pdf