DeepSeekV3技术报告.pdf

DeepSeek AI 推出了 DeepSeek-V3,这是一个强大的混合专家(MoE)语言模型,总参数为 671B,每个 token 激活 37B。DeepSeek-V3 采用了多头潜在注意力(MLA)和 DeepSeekMoE 架构,并开创了一种无辅助损失的负载平衡策略,设定了多 token 预测训练目标。

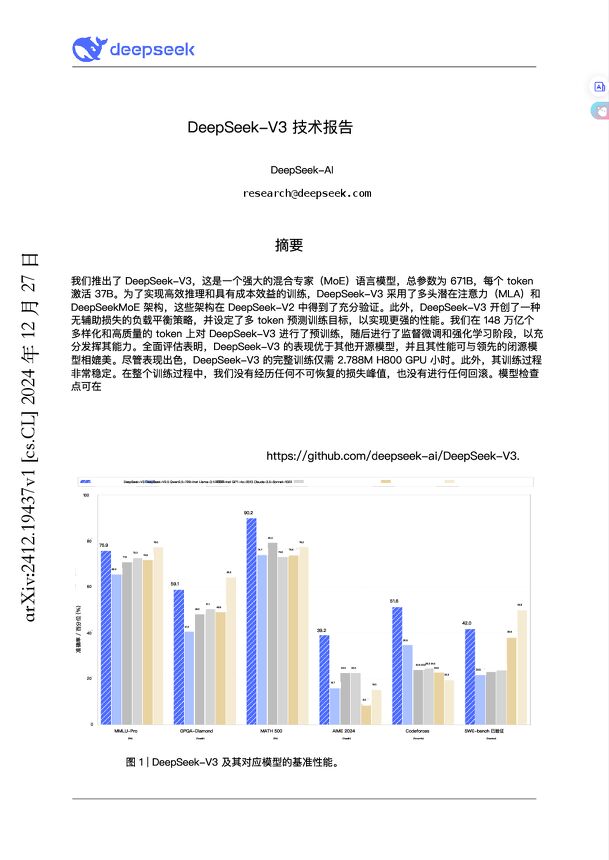

DeepSeek-V3 在 14.8T 多样化和高质量的 token 上进行了预训练,并进行了监督微调和强化学习。评估表明,DeepSeek-V3 的表现优于其他开源模型,性能可与领先的闭源模型相媲美。DeepSeek-V3 的完整训练仅需 2.788M H800 GPU 小时。

DeepSeek-V3 的主要贡献包括:

* 架构:创新的负载均衡策略和训练目标,开创了一种无辅助损失的负载均衡策略,研究了一种多标记预测(MTP)目标。

* 预训练:设计了 FP8 混合精度训练框架,克服了跨节点 MoE 训练中的通信瓶颈,以 2.664M H800 GPU 小时的经济成本,在 14.8T 标记上完成了预训练。

* 后训练:引入了一种创新的方法,将推理能力从长链思维模型中提炼出来,并显著提高其推理性能。

DeepSeek-V3 的评估结果摘要:

* 知识:在教育基准测试和 GPQA 上,DeepSeek-V3 的表现优于其他开源模型。

* 代码、数学和推理:DeepSeek-V3 在所有非长链思维的开源和闭源模型中,在与数学相关的基准测试中达到了最先进的性能,在与编码相关的任务中,DeepSeek-V3 成为编码竞赛基准测试中表现最好的模型。

为了促进 DeepSeek-V3 的高效训练,实施了细致的工程优化。设计了 DualPipe 算法以实现高效的管道并行性,解决了跨节点专家并行性带来的高通信开销问题。开发了高效的跨节点全到全通信内核,并节省专用于通信的流处理器。在训练过程中细致优化内存占用,从而使我们能够在不使用昂贵的张量并行性的情况下训练 DeepSeek-V3。

为了解决激活、权重和梯度中异常值的限制,DeepSeek 提出了一种细粒度量化策略。

相关报告

-

7.1 MB 57页 2025年数字化、信息化、AI技术演进与产业变革新图景报告.pdf

-

8.42 MB 108页 2025年技术趋势报告-麦肯锡.pdf

-

17.39 MB 41页 2024中国智算产业全景调研:技术重构与演进报告-与非网-202506.pdf

-

5.78 MB 45页 2025年抗衰老产业报告:政策、市场与技术的融合-毕马威-202504.pdf

-

883.52 KB 15页 全球技术报告:金融服务业洞察.pdf

-

3.83 MB 43页 2025年AI驱动的主配变智能监测与预警技术及系统报告.pdf

-

7.94 MB 86页 2024气象人工智能技术与应用报告.pdf

-

1.1 MB 16页 全球技术报告:能源行业洞察-15页.pdf

-

8.73 MB 145页 产权组织技术趋势:交通运输的未来报告.pdf

-

3.72 MB 92页 2024年数据中心供柴油系统技术报告.pdf

-

16.19 MB 38页 2025年技术趋势报告-德勤-202502.pdf

-

3.83 MB 40页 2025年技术预测报告.pdf

-

1.01 MB 16页 2025全球技术报告之能源行业洞察.pdf

-

14.72 MB 26页 月狐报告|技术深化、领域融合,持续增长的AI市场-AI行业月度报告(2024.9).pdf

-

5.52 MB 88页 2024贝恩咨询公司年度《2024全球技术报告.pdf

-

6.08 MB 23页 动漫产业的创新驱动:3D动漫制作技术如何引领视觉艺术新潮流 头豹词条报告系列.pdf

-

3.89 MB 46页 2024年十大新兴技术报告(英)-世界经济论坛-2024.6-46页.pdf

-

3.2 MB 86页 2024年十大数字技术趋势与其安全挑战报告.pdf